Mengenal Lebih Dalam Robots.txt Khusus - Delapan belas bulan yang lalu saya sudah menuliskan artikel tentang cara memasang robots.txt khusus, namun disana saya belum menjelaskan secara spesifik mengenai robots.txt khusus tersebut dan kali ini saya akan mencoba membahas dan menjelaskan lebih dalam mengenai robots.txt khusus ini. Search engine seperti google misalnya pada dasarnya sudah memiliki setelan default robots.txt pada robot crawl (perayap google).

Perintah yang paling mendasar pada robots.txt default perayap google adalah merayapi semua bagian laman situs terkecuali laman pencarian (search). Itu sebabnya konten unik dari blogger pemula tetap dapat terindex dan muncul dihasil pencarian google meskipun tanpa melakukan Submit url maupun Fetch as Google. Dan peran robots.txt khusus pada sebuah laman web adalah untuk membatasi perayapan yang dilakukan oleh robot crawl, itulah penyebab kenapa pengembang situs dianjurkan agar berhati-hati dalam menggunakan robots.txt khusus.

Bagaimana Contoh Robots.txt Default

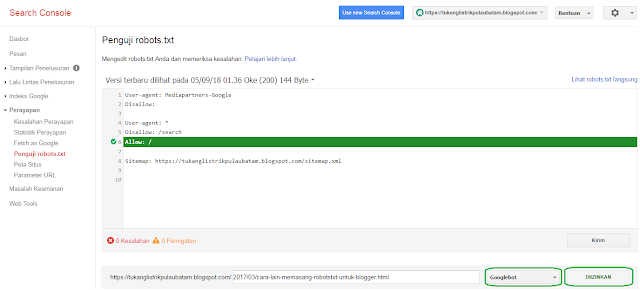

Robots.txt Default Google dapat dilihat melaui search console atau biasa disebut dengan webmaster tool, buatlah situs web barutanpa robots.txt khusus kemudian tambahkan ke situs search console, kemudian verifikasi kepemilikan situs, lalu buka tab Crawl pada search console dan lihat pada bagian Robots.txt Tester.

Disana kamu dapat melihat pengaturan Robots.txt Default google dan kamu dapat menguji pengaturan Robots.txt tersebut dengan 7 bot google yaitu: Googlebot, Googlebot-News, Googlebot-Image, Googlebot-Video, Googlebot-Mobile, Mediapartners-Google, Adsbot-Google.

Lihat contoh gambar dibawah ini;

Jika pada saat pengujian robots.txt tertera "diizinkan" itu artinya googlebot dapat mengakses dan merayapi situs, jika tertera "dicekal" itu artinya googlebot tidak diizinkan untuk merayapi url situs. Ujilah url situs anda dengan 7 jenis googlebot seperti diatas, jika semua berstatus "diizinkan" maka pengaturan robots.txt tersebut sudah benar. Copy kode robots.txt nya kemudian pasang ke pengaturan situs blogger anda agar tool penguji SEO (Search Engine Optimization) dapat membacanya.

Kode Robots.txt Dasar (Default)

Pada sebuah laman situs web terdapat halaman yang privasi atau bersifat rahasia atau halaman yang berlawanan dengan kebijakan google, Nah, pada kasus seperti ini pengelola situs dapat menggunakan robots.txt khusus untuk membatasi perayapan dan peng-index-an robot crawl pada laman tersebut.

Contoh:

Jika tidak ada laman yang bersifat rahasia (privasi) maka kita tidak perlu melakukan pembatasan akses terhadap robot crawl (perayap google), Dianjurkan "cukup" gunakan pengaturan default robots.txt, setelah benar-benar paham silahkan berkreasi dengan Robots.txt Khusus.

Upload File Robots.txt Khusus ke Webmaster (Search Console)

Demikian penjelasan tentang "robots.txt khusus" dari saya semoga bermanfaat dan menambah ilmu pengetahuan. Artikel ini saya dedikasikan kepada para blogger khususnya visitor yang menanyakan "kenapa kode robots.txt disini pendek sedangkan di situs tetangga sebelah panjang". Jika dipahami dengan benar maka artikel ini sudah cukup untuk menjawab-nya. Mohon maaf saya tidak mempublikasikan komentar beliau karena tidak subscribe dulu baru komentar, sekian.

Perintah yang paling mendasar pada robots.txt default perayap google adalah merayapi semua bagian laman situs terkecuali laman pencarian (search). Itu sebabnya konten unik dari blogger pemula tetap dapat terindex dan muncul dihasil pencarian google meskipun tanpa melakukan Submit url maupun Fetch as Google. Dan peran robots.txt khusus pada sebuah laman web adalah untuk membatasi perayapan yang dilakukan oleh robot crawl, itulah penyebab kenapa pengembang situs dianjurkan agar berhati-hati dalam menggunakan robots.txt khusus.

|

| Mengenal Lebih Dalam Robots.txt Khusus |

Robots.txt Default Google dapat dilihat melaui search console atau biasa disebut dengan webmaster tool, buatlah situs web baru

Disana kamu dapat melihat pengaturan Robots.txt Default google dan kamu dapat menguji pengaturan Robots.txt tersebut dengan 7 bot google yaitu: Googlebot, Googlebot-News, Googlebot-Image, Googlebot-Video, Googlebot-Mobile, Mediapartners-Google, Adsbot-Google.

Lihat contoh gambar dibawah ini;

|

| Robots.txt default |

Kode Robots.txt Dasar (Default)

User-agent: Mediapartners-GoogleSekarang bagaimana contoh robots.txt khusus? Setelah mengetahui pengaturan default robots.txt maka sangat mudah untuk memahami robots.txt khusus, "Khusus" yang dimaksud pada pengaturan robots.txt adalah pengaturan optional dari pihak pengelola situs untuk mengatur akses robot crawl, misalnya;

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://yoursitename.blogspot.com/sitemap.xml

Pada sebuah laman situs web terdapat halaman yang privasi atau bersifat rahasia atau halaman yang berlawanan dengan kebijakan google, Nah, pada kasus seperti ini pengelola situs dapat menggunakan robots.txt khusus untuk membatasi perayapan dan peng-index-an robot crawl pada laman tersebut.

Contoh:

User-agent: Mediapartners-GooglePerhatikan dua baris kode "Disallow" yang ditandai dengan huruf tebal diatas adalah contoh robots.txt khusus, kedua url tersebut tidak akan dirayapi oleh robot.crawl dan tidak ditampilkan pada laman hasil pencarian. Jadi sangat bisa dipahami kan bahwa robots.txt khusus merupakan pengaturan optional/pengaturan kita sendiri untuk membatasi akses robot crawl dalam merayapi situs kita.

Disallow:

User-agent: *

Disallow: /search

Disallow: /p/cepika-cepiki.html

Disallow: /document-privacy.html

Allow: /

Sitemap: https://yoursitename.blogspot.com/sitemap.xml

Jika tidak ada laman yang bersifat rahasia (privasi) maka kita tidak perlu melakukan pembatasan akses terhadap robot crawl (perayap google), Dianjurkan "cukup" gunakan pengaturan default robots.txt, setelah benar-benar paham silahkan berkreasi dengan Robots.txt Khusus.

Upload File Robots.txt Khusus ke Webmaster (Search Console)

Bagaimana cara meng-update atau meng-upload robots.txt khusus dari situs blogger ke webmaster tool (search console)?Memperbaharui robots.txt khusus baik itu menambah atau mengurangi robots.txt dilakukan melalui dashboard "settingan" blogger, lalu kemudian masuk ke search console dan buka fitur robots.txt tester, tekan tombol submit untuk mengupdate / upload robots.txt. Biasanya akan muncul pop-up yang berisi 3 pilihan, silahkan pilih submit untuk pembaharuan robots.txt, setelah selesai lakukan refresh pada search console untuk melihat hasilnya.

Demikian penjelasan tentang "robots.txt khusus" dari saya semoga bermanfaat dan menambah ilmu pengetahuan. Artikel ini saya dedikasikan kepada para blogger khususnya visitor yang menanyakan "kenapa kode robots.txt disini pendek sedangkan di situs tetangga sebelah panjang". Jika dipahami dengan benar maka artikel ini sudah cukup untuk menjawab-nya. Mohon maaf saya tidak mempublikasikan komentar beliau karena tidak subscribe dulu baru komentar, sekian.

Tags:

Seo Blogger